Technologie-Peripherieger?te

Technologie-Peripherieger?te

KI

KI

Das erste Weltmodell zur Erzeugung autonomer Fahrszenen mit mehreren Ansichten | DrivingDiffusion: Neue Ideen für BEV-Daten und Simulation

Das erste Weltmodell zur Erzeugung autonomer Fahrszenen mit mehreren Ansichten | DrivingDiffusion: Neue Ideen für BEV-Daten und Simulation

Das erste Weltmodell zur Erzeugung autonomer Fahrszenen mit mehreren Ansichten | DrivingDiffusion: Neue Ideen für BEV-Daten und Simulation

Oct 23, 2023 am 11:13 AMEinige pers?nliche Gedanken des Autors

Im Bereich des autonomen Fahrens mit der Entwicklung von BEV-basierten Teilaufgaben/End-to-End-L?sungen, hochwertigen Multi-View-Trainingsdaten und entsprechender Simulation Szenenaufbau werden immer wichtiger. Als Reaktion auf die Schmerzpunkte aktueller Aufgaben l?sst sich ?hohe Qualit?t“ in drei Aspekte entkoppeln:

- Long-Tail-Szenarien in verschiedenen Dimensionen: wie z. B. Nahbereichsfahrzeuge in Hindernisdaten und pr?zise Kurswinkel beim Autoschneiden , Sowie Szenarien wie Kurven mit unterschiedlichen Krümmungen oder Rampen/Zusammenführungen/Zusammenführungen, die in Fahrspurliniendaten schwer zu erfassen sind. Diese basieren h?ufig auf der Sammlung gro?er Datenmengen und komplexen Data-Mining-Strategien, die kostspielig sind.

- Echter 3D-Wert – hohe Konsistenz der Bilder: Die aktuelle BEV-Datenerfassung wird h?ufig durch Fehler bei der Sensorinstallation/-kalibrierung, hochpr?zisen Karten und dem Rekonstruktionsalgorithmus selbst beeintr?chtigt. Dadurch ist es für uns schwierig sicherzustellen, dass jeder Satz von [3D-Echtwerte-Bildsensorparameter] in den Daten genau und konsistent ist.

- Zeitreihendaten basierend auf der Erfüllung der oben genannten Bedingungen: Mehransichtsbilder aufeinanderfolgender Frames und entsprechende wahre Werte, die für die aktuelle Wahrnehmung/Vorhersage/Entscheidungsfindung/End-to-End- und andere Aufgaben wesentlich sind.

Für die Simulation kann die Videogenerierung, die die oben genannten Bedingungen erfüllt, direkt über das Layout generiert werden. Dies ist zweifellos der direkteste Weg, um Multi-Agent-Sensoreingaben zu erstellen. DrivingDiffusion l?st die oben genannten Probleme aus einer neuen Perspektive.

Was ist DrivingDiffusion?

- DrivingDiffusion ist ein Diffusionsmodell-Framework für die Generierung autonomer Fahrszenen, das die Layout-gesteuerte Multi-View-Bild-/Video-Generierung bzw. SOTA implementiert. DrivingDiffusion-Future hat als selbstfahrendes Weltmodell die F?higkeit, zukünftige Szenenvideos basierend auf Einzelbildbildern vorherzusagen und die Bewegungsplanung des Hauptfahrzeugs/anderer Fahrzeuge

- basierend auf Sprachanweisungen zu beeinflussen. Was ist der Generierungseffekt von DrivingDiffusion?

Studenten in Not k?nnen zun?chst einen Blick auf die Projekthomepage werfen: https://drivingdiffusion.github.io

(1) DrivingDiffusion

Multiperspektivische Bildgenerierung mit Layoutsteuerung

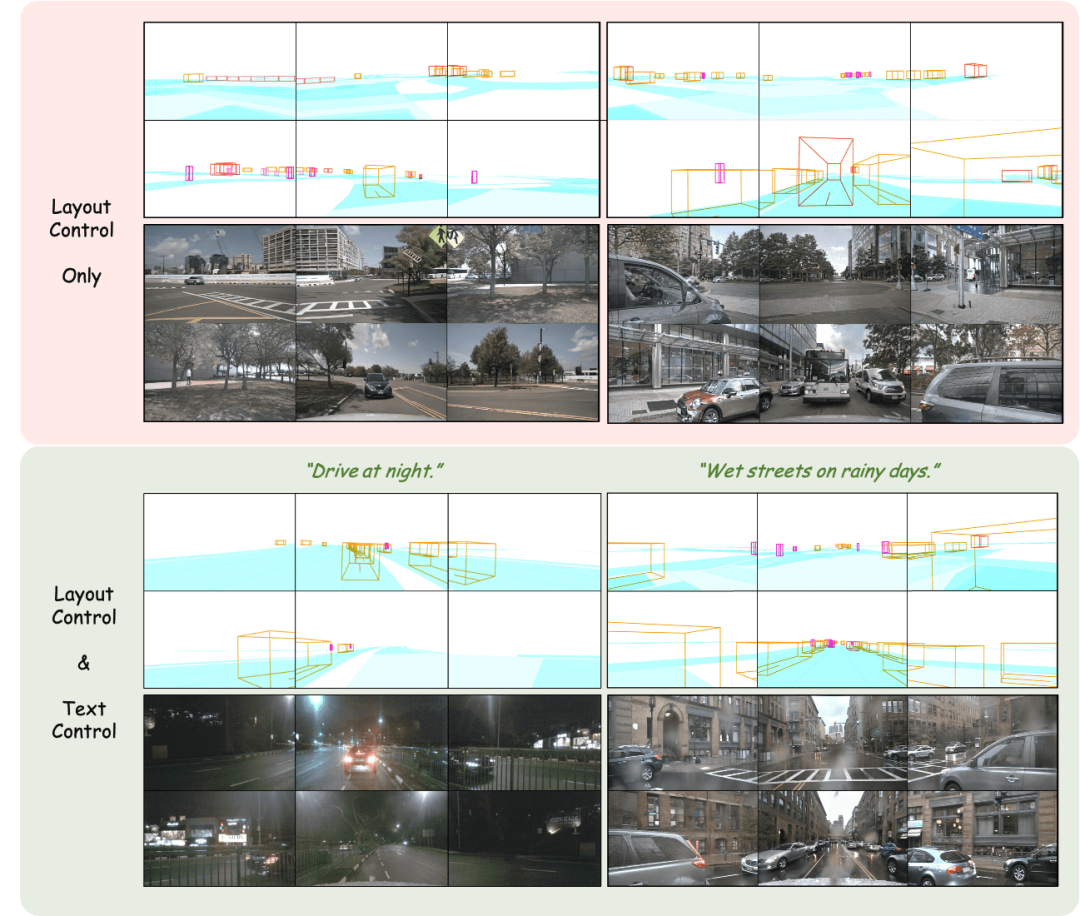

Im Bild gezeigt Der Effekt der Mehransichtsbildgenerierung unter Verwendung der Layoutprojektion als Eingabe wird erzielt.

Layout anpassen: Pr?zise Steuerung der generierten Ergebnisse

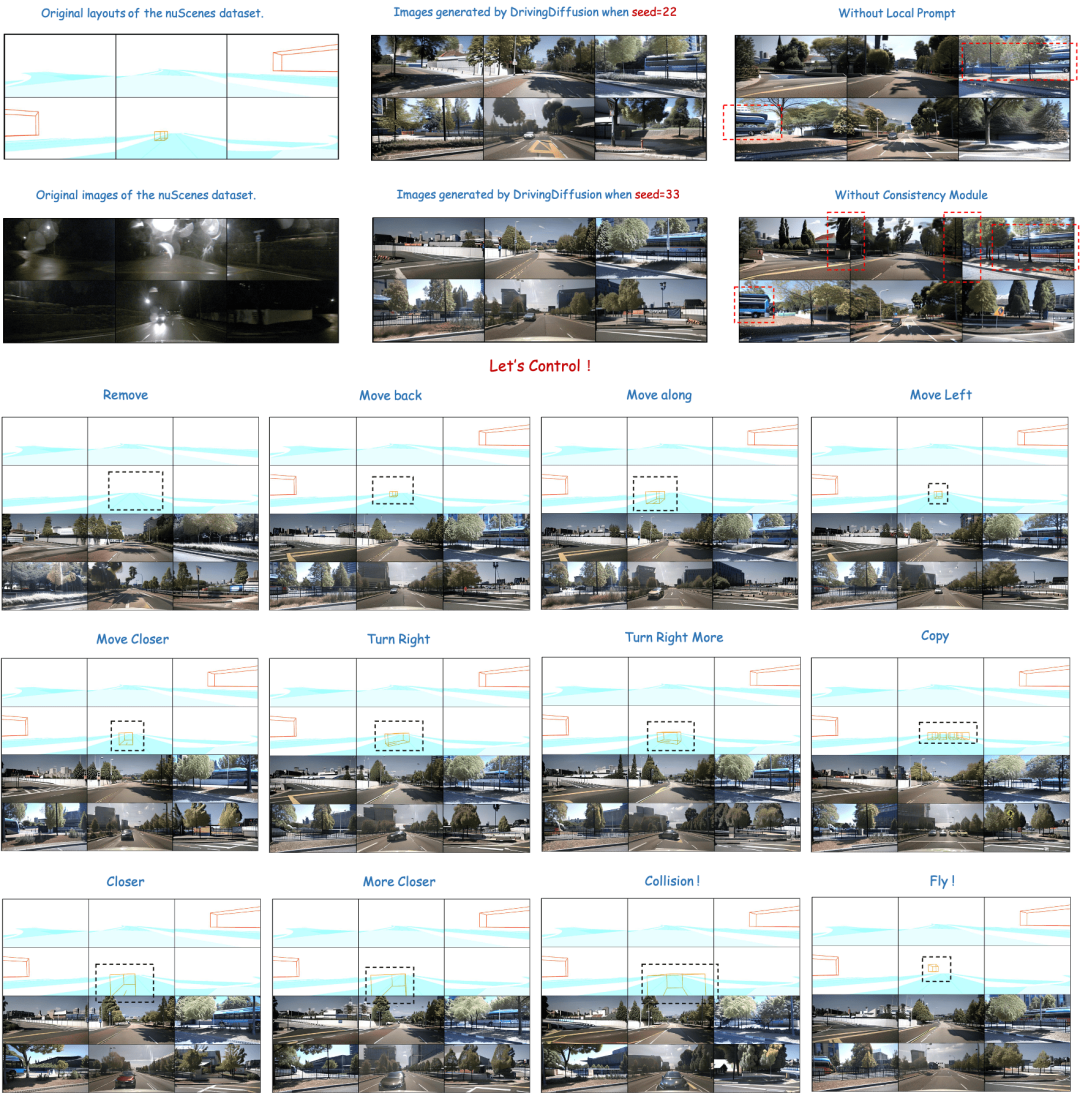

Der obere Teil der Abbildung zeigt die Vielfalt der generierten Ergebnisse und die Bedeutung des Moduldesigns unten. Der untere Teil zeigt die Folgen der St?rung des Fahrzeugs direkt dahinter, einschlie?lich der Erzeugungseffekte durch Bewegen, Drehen, Zusammensto?en und sogar Schweben in der Luft.

Layoutgesteuerte Multi-View-Videogenerierung

Oben: Ergebnisse der Videogenerierung von DrivingDiffusion nach dem Training mit nuScenes-Daten. Unten: Ergebnisse der Videogenerierung von DrivingDiffusion nach dem Training mit einer gro?en Menge privater realer Daten. 2) DrivingDiffusion-Future das Hauptauto/andere Autos. Die ersten drei Zeilen und die vierte Zeile in der Abbildung zeigen jeweils den Generierungseffekt nach der Textbeschreibungssteuerung des Verhaltens des Hauptfahrzeugs und anderer Fahrzeuge. (Das grüne Feld ist die Eingabe, das blaue Feld ist die Ausgabe)

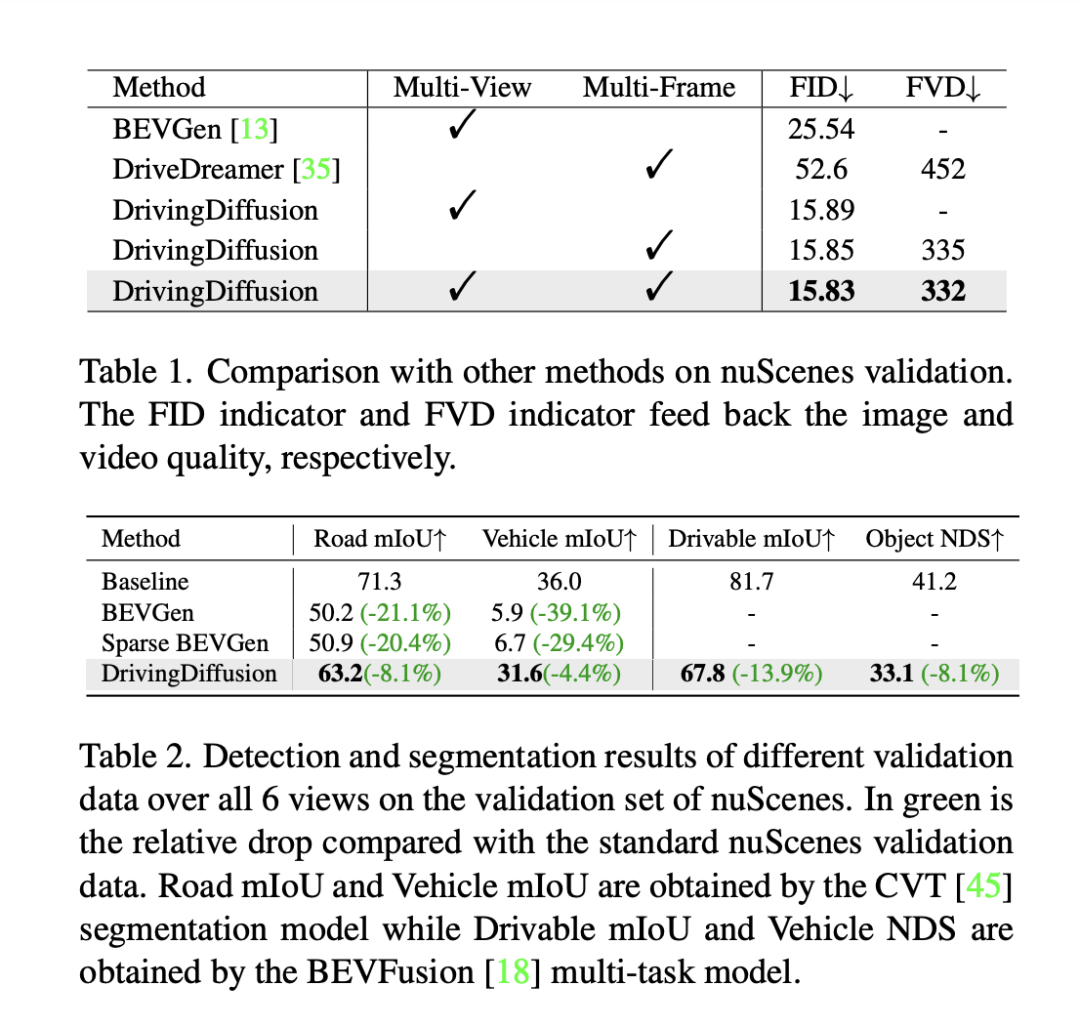

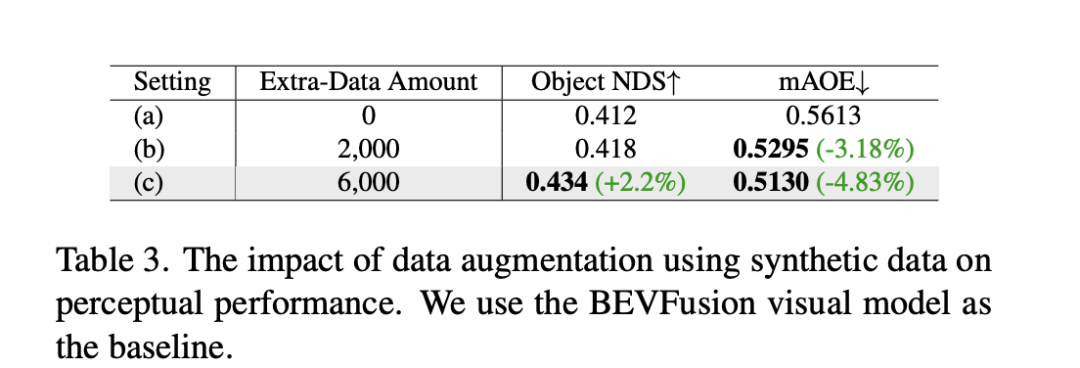

Erzeugt direkt nachfolgende Frames basierend auf dem Eingabeframe

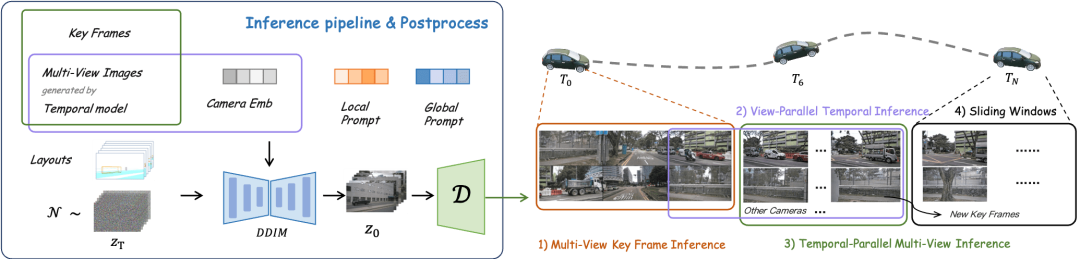

Es ist keine weitere Steuerung erforderlich, nur ein einzelnes Frame-Bild wird als Eingabe für die Vorhersage verwendet die Fahrszene der nachfolgenden Frames. (Grünes Feld ist Eingabe, blaues Feld ist Ausgabe) DrivingDiffusion konstruiert zun?chst künstlich alle wahren 3D-Werte (Hindernisse/Stra?enstrukturen) in der Szene. Nach der Projektion der wahren Werte in Layoutbilder wird es als Modelleingabe verwendet, um echte Bilder/Videos von mehreren Kameras zu erhalten Perspektiven. Der Grund, warum 3D-True-Werte (BEV-Ansichten oder codierte Instanzen) nicht direkt als Modelleingabe verwendet werden, sondern Parameter für die Post-Projektion-Eingabe verwendet werden, besteht darin, systematische 3D-2D-Konsistenzfehler zu beseitigen. (In einem solchen Datensatz werden 3D-Echtwerte und Fahrzeugparameter entsprechend den tats?chlichen Anforderungen künstlich konstruiert. Ersteres bietet die M?glichkeit, seltene Szenendaten nach Belieben zu erstellen , und letzteres eliminiert herk?mmliche Datenproduktionsfehler geometrische Konsistenz) sequentielle Multi-View-Ansichten basierend auf künstlich konstruierten Szenen und Fahrzeugparametern, die nicht nur als Trainingsdaten für nachgelagerte autonome Fahraufgaben verwendet werden k?nnen, sondern auch ein Simulationssystem für Feedback zum autonomen Fahren aufbauen k?nnen Fahralgorithmen. Bei der Generierung von Multi-View-Videos gibt es mehrere Schwierigkeiten: DrivingDiffusion erzeugt einen langen Videoprozess verwendet Keyframes als zus?tzliche Steuerung, Multi-View-Shared-Single-View-Timing-Modell: führt Timing aus jede Ansicht parallel Erweiterung, Das Konsistenzmodul ist in zwei Teile unterteilt: Konsistenz-Aufmerksamkeitsmechanismus und Konsistenzassoziationsverlust. Der Konsistenz-Aufmerksamkeitsmechanismus konzentriert sich auf die Interaktion zwischen benachbarten Ansichten und zeitlich verbundenen Frames. Für die Cross-Frame-Konsistenz konzentriert er sich insbesondere auf die Informationsinteraktion zwischen linken und rechten benachbarten Ansichten mit überlappung Der Fokus liegt auf dem Schlüsselbild und dem vorherigen Bild. Dadurch wird der enorme Rechenaufwand vermieden, der durch globale Interaktionen verursacht wird. Der konsistente Korrelationsverlust fügt geometrische Einschr?nkungen durch pixelweise Korrelation und Regression der Pose hinzu, deren Gradient von einem vorab trainierten Pose-Regressor bereitgestellt wird. Der Regressor fügt einen auf LoFTR basierenden Posenregressionskopf hinzu und trainiert ihn unter Verwendung der wahren Posenwerte auf den realen Daten des entsprechenden Datensatzes. Bei Multi-View-Modellen und Zeitreihenmodellen überwacht dieses Modul die relative Kameraposition bzw. die Hauptbewegungsposition des Fahrzeugs. Local Prompt und Global Prompt arbeiten zusammen, um die Parametersemantik von CLIP und Stable-Diffusion-v1-4 wiederzuverwenden, um bestimmte Kategorieinstanzbereiche lokal zu verbessern. Wie in der Abbildung gezeigt, entwirft der Autor basierend auf dem Kreuzaufmerksamkeitsmechanismus von Bild-Token und globalen Textbeschreibungsaufforderungen eine lokale Eingabeaufforderung für eine bestimmte Kategorie und verwendet das Bild-Token im Maskenbereich der Kategorie, um die lokale Abfrage abzufragen prompt. Dieser Prozess nutzt das Konzept der textgesteuerten Bildgenerierung im offenen Bereich in den ursprünglichen Modellparametern maximal aus. Für zukünftige Szenenkonstruktionsaufgaben verwendet DrivingDiffusion-Future zwei Methoden: Eine besteht darin, nachfolgende Rahmenbilder (visueller Zweig) direkt aus dem ersten Rahmenbild vorherzusagen, und die Verwendung inter- Rahmen optischer Fluss als Hilfsverlust. Diese Methode ist relativ einfach, aber der Effekt der Generierung nachfolgender Frames basierend auf Textbeschreibungen ist durchschnittlich. Eine andere M?glichkeit besteht darin, einen neuen Konzeptzweig hinzuzufügen, der auf dem ersteren basiert und die BEV-Ansicht nachfolgender Frames anhand der BEV-Ansicht des ersten Frames vorhersagt. Dies liegt daran, dass die Vorhersage der BEV-Ansicht dem Modell hilft, die Kerninformationen des Fahrens zu erfassen in Szene setzen und Konzepte etablieren. Zu diesem Zeitpunkt wirkt die Textbeschreibung gleichzeitig auf beide Zweige, und die Merkmale des Konzeptzweigs werden über das Perspektivenkonvertierungsmodul von BEV2PV auf den visuellen Zweig angewendet. Einige Parameter des Perspektivenkonvertierungsmoduls werden mithilfe von vorab trainiert Echtwertbilder, um die Rauscheingabe zu ersetzen (und im Freeze w?hrend des nachfolgenden Trainings). Es ist erw?hnenswert, dass der Hauptfahrzeugsteuerungs-Textbeschreibungscontroller und der Andere Fahrzeugsteuerungs-/Umgebungstextbeschreibungscontroller entkoppelt sind. Um die Leistung des Modells zu bewerten, verwendet DrivingDiffusion die Fréchet Inception Distance (FID) auf Frame-Ebene, um die Qualit?t der generierten Bilder zu bewerten, und verwendet dementsprechend FVD, um die Qualit?t der generierten Videos zu bewerten. Alle Metriken werden anhand des nuScenes-Validierungssatzes berechnet. Wie in Tabelle 1 gezeigt, bietet DrivingDiffusion im Vergleich zur Bildgenerierungsaufgabe BEVGen und der Videogenerierungsaufgabe DriveDreamer in autonomen Fahrszenarien gr??ere Vorteile bei den Leistungsindikatoren unter verschiedenen Einstellungen. Obwohl Methoden wie FID h?ufig zur Messung der Qualit?t der Bildsynthese verwendet werden, geben sie weder die Designziele der Aufgabe vollst?ndig wieder, noch spiegeln sie die Qualit?t der Synthese für verschiedene semantische Kategorien wider. Da es sich bei der Aufgabe um die Generierung von Multi-View-Bildern im Einklang mit dem 3D-Layout handelt, schl?gt DrivingDiffuison vor, die Metrik des BEV-Wahrnehmungsmodells zu verwenden, um die Leistung im Hinblick auf die Konsistenz zu messen: Verwendung der offiziellen Modelle von CVT und BEVFusion als Evaluatoren unter Verwendung desselben realen 3D Modell als nuScenes-Validierungssatz. Generieren Sie Bilder abh?ngig vom Layout, führen Sie CVT- und BevFusion-Inferenz für jeden Satz generierter Bilder durch und vergleichen Sie dann die vorhergesagten Ergebnisse mit den tats?chlichen Ergebnissen, einschlie?lich der durchschnittlichen Schnittmenge über U (mIoU) des befahrbaren Bereichs und die NDS aller Objektklassen. Die Statistiken sind in Tabelle 2 dargestellt. Experimentelle Ergebnisse zeigen, dass die Wahrnehmungsindikatoren des Bewertungssatzes für synthetische Daten denen des realen Bewertungssatzes sehr nahe kommen, was die hohe Konsistenz der generierten Ergebnisse und wahren 3D-Werte sowie die hohe Wiedergabetreue der Bildqualit?t widerspiegelt. Zus?tzlich zu den oben genannten Experimenten führte DrivingDiffusion Experimente zum Hinzufügen von Training mit synthetischen Daten durch, um das Hauptproblem anzugehen, das dadurch gel?st wurde – die Verbesserung der Leistung nachgelagerter Aufgaben des autonomen Fahrens. Tabelle 3 zeigt die Leistungsverbesserungen, die durch die Erweiterung synthetischer Daten bei BEV-Wahrnehmungsaufgaben erzielt werden. In den ursprünglichen Trainingsdaten gibt es Probleme mit Long-Tail-Verteilungen, insbesondere bei kleinen Zielen, Fahrzeugen im Nahbereich und Fahrzeugausrichtungswinkeln. DrivingDiffusion konzentriert sich auf die Generierung zus?tzlicher Daten für diese Klassen mit begrenzten Stichproben, um dieses Problem zu l?sen. Nach dem Hinzufügen von 2000 Datenrahmen, die sich auf die Verbesserung der Verteilung der Hindernisausrichtungswinkel konzentrierten, verbesserte sich der NDS leicht, w?hrend der mAOE deutlich von 0,5613 auf 0,5295 sank. Nach der Verwendung von 6.000 Frames synthetischer Daten, die umfassender sind und sich auf seltene Szenen konzentrieren, um das Training zu unterstützen, ist beim nuScenes-Validierungssatz eine deutliche Verbesserung zu beobachten: NDS stieg von 0,412 auf 0,434 und mAOE sank von 0,5613 auf 0,5130. Dies zeigt die signifikante Verbesserung, die die Datenerweiterung synthetischer Daten für Wahrnehmungsaufgaben bringen kann. Benutzer k?nnen anhand des tats?chlichen Bedarfs Statistiken über die Verteilung jeder Dimension in den Daten erstellen und diese dann durch gezielte synthetische Daten erg?nzen. DrivingDiffusion realisiert gleichzeitig die F?higkeit, Multi-View-Videos von autonomen Fahrszenen zu erstellen und die Zukunft vorherzusagen, was für autonome Fahraufgaben von gro?er Bedeutung ist. Darunter sind Layout und Parameter alle künstlich konstruiert und die Konvertierung zwischen 3D und 2D erfolgt durch Projektion, anstatt sich auf erlernbare Modellparameter zu verlassen. Dies eliminiert geometrische Fehler im vorherigen Prozess der Datenbeschaffung und hat einen hohen praktischen Wert. Gleichzeitig ist DrivingDiffuison ?u?erst skalierbar und unterstützt neue Szeneninhaltslayouts und zus?tzliche Controller. Au?erdem kann die Generierungsqualit?t durch Superaufl?sung und Video-Frame-Einfügungstechnologie verlustfrei verbessert werden. In der autonomen Fahrsimulation gibt es immer mehr Nerf-Versuche. Allerdings bringt die Aufgabe der Street View-Generierung, die Trennung von dynamischem und statischem Inhalt, die gro?fl?chige Blockrekonstruktion, die Entkoppelung des Erscheinungsbilds, die Kontrolle von Wetter und anderen Dimensionen usw. mit sich. Darüber hinaus erfordert Nerf oft einen enormen Arbeitsaufwand Erst nach dem Training kann es in nachfolgenden Simulationen neue Perspektivensyntheseaufgaben unterstützen. DrivingDiffusion enth?lt natürlich ein gewisses Ma? an allgemeinem Wissen, einschlie?lich visueller Textverbindungen, konzeptionellem Verst?ndnis visueller Inhalte usw. Es kann schnell eine Szene entsprechend den Anforderungen erstellen, indem einfach das Layout erstellt wird. Wie oben erw?hnt, ist der gesamte Prozess jedoch relativ komplex und die Erstellung langer Videos erfordert eine Feinabstimmung und Erweiterung des Nachbearbeitungsmodells. DrivingDiffusion wird weiterhin die Komprimierung von Perspektiven- und Zeitdimensionen erforschen, Nerf für die Generierung und Konvertierung neuer Perspektiven kombinieren und die Generierungsqualit?t und Skalierbarkeit weiter verbessern. Wie l?st DrivingDiffusion die oben genannten Probleme?

überblick über die DrivingDiffusion-Methode

Im Vergleich zur herk?mmlichen Bildgenerierung fügt die Multi-View-Videogenerierung zwei neue Dimensionen hinzu:

Single-Frame-Multi-View-Modell: generiert Multi-View-Keyframes,

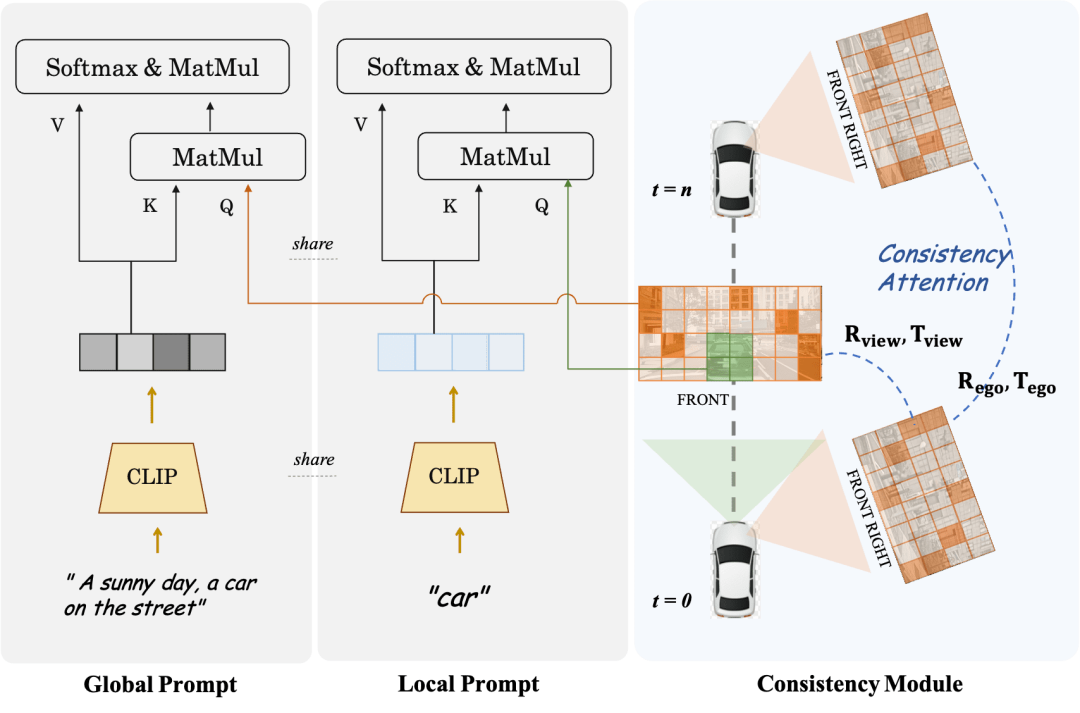

Konsistenzmodul und lokale Eingabeaufforderung

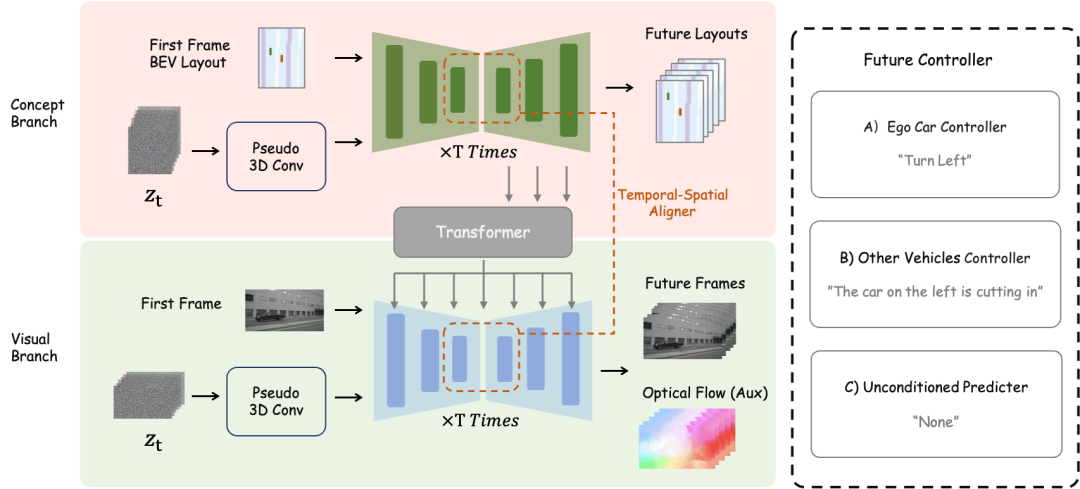

übersicht über die DrivingDiffusion-Future-Methode

Experimentelle Analyse

Die Bedeutung und zukünftige Arbeit von DrivingDiffusion

Das obige ist der detaillierte Inhalt vonDas erste Weltmodell zur Erzeugung autonomer Fahrszenen mit mehreren Ansichten | DrivingDiffusion: Neue Ideen für BEV-Daten und Simulation. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Hei?e KI -Werkzeuge

Undress AI Tool

Ausziehbilder kostenlos

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem v?llig kostenlosen KI-Gesichtstausch-Tool aus!

Hei?er Artikel

Hei?e Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Warum ist Gaussian Splatting beim autonomen Fahren so beliebt, dass NeRF allm?hlich aufgegeben wird?

Jan 17, 2024 pm 02:57 PM

Warum ist Gaussian Splatting beim autonomen Fahren so beliebt, dass NeRF allm?hlich aufgegeben wird?

Jan 17, 2024 pm 02:57 PM

Oben geschrieben und pers?nliches Verst?ndnis des Autors. Dreidimensionales Gaussplatting (3DGS) ist eine transformative Technologie, die in den letzten Jahren in den Bereichen explizite Strahlungsfelder und Computergrafik entstanden ist. Diese innovative Methode zeichnet sich durch die Verwendung von Millionen von 3D-Gau?kurven aus, was sich stark von der Neural Radiation Field (NeRF)-Methode unterscheidet, die haupts?chlich ein implizites koordinatenbasiertes Modell verwendet, um r?umliche Koordinaten auf Pixelwerte abzubilden. Mit seiner expliziten Szenendarstellung und differenzierbaren Rendering-Algorithmen garantiert 3DGS nicht nur Echtzeit-Rendering-F?higkeiten, sondern führt auch ein beispielloses Ma? an Kontrolle und Szenenbearbeitung ein. Dies positioniert 3DGS als potenziellen Game-Changer für die 3D-Rekonstruktion und -Darstellung der n?chsten Generation. Zu diesem Zweck geben wir erstmals einen systematischen überblick über die neuesten Entwicklungen und Anliegen im Bereich 3DGS.

Wie l?sst sich das Long-Tail-Problem in autonomen Fahrszenarien l?sen?

Jun 02, 2024 pm 02:44 PM

Wie l?sst sich das Long-Tail-Problem in autonomen Fahrszenarien l?sen?

Jun 02, 2024 pm 02:44 PM

Gestern wurde ich w?hrend des Interviews gefragt, ob ich irgendwelche Long-Tail-Fragen gestellt h?tte, also dachte ich, ich würde eine kurze Zusammenfassung geben. Das Long-Tail-Problem des autonomen Fahrens bezieht sich auf Randf?lle bei autonomen Fahrzeugen, also m?gliche Szenarien mit geringer Eintrittswahrscheinlichkeit. Das wahrgenommene Long-Tail-Problem ist einer der Hauptgründe, die derzeit den betrieblichen Designbereich intelligenter autonomer Einzelfahrzeugfahrzeuge einschr?nken. Die zugrunde liegende Architektur und die meisten technischen Probleme des autonomen Fahrens wurden gel?st, und die verbleibenden 5 % der Long-Tail-Probleme wurden nach und nach zum Schlüssel zur Einschr?nkung der Entwicklung des autonomen Fahrens. Zu diesen Problemen geh?ren eine Vielzahl fragmentierter Szenarien, Extremsituationen und unvorhersehbares menschliches Verhalten. Der ?Long Tail“ von Randszenarien beim autonomen Fahren bezieht sich auf Randf?lle in autonomen Fahrzeugen (AVs). Randf?lle sind m?gliche Szenarien mit geringer Eintrittswahrscheinlichkeit. diese seltenen Ereignisse

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, ?ffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, ?ffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

In diesem Artikel wird das Problem der genauen Erkennung von Objekten aus verschiedenen Blickwinkeln (z. B. Perspektive und Vogelperspektive) beim autonomen Fahren untersucht, insbesondere wie die Transformation von Merkmalen aus der Perspektive (PV) in den Raum aus der Vogelperspektive (BEV) effektiv ist implementiert über das Modul Visual Transformation (VT). Bestehende Methoden lassen sich grob in zwei Strategien unterteilen: 2D-zu-3D- und 3D-zu-2D-Konvertierung. 2D-zu-3D-Methoden verbessern dichte 2D-Merkmale durch die Vorhersage von Tiefenwahrscheinlichkeiten, aber die inh?rente Unsicherheit von Tiefenvorhersagen, insbesondere in entfernten Regionen, kann zu Ungenauigkeiten führen. W?hrend 3D-zu-2D-Methoden normalerweise 3D-Abfragen verwenden, um 2D-Features abzutasten und die Aufmerksamkeitsgewichte der Korrespondenz zwischen 3D- und 2D-Features über einen Transformer zu lernen, erh?ht sich die Rechen- und Bereitstellungszeit.

SIMPL: Ein einfacher und effizienter Multi-Agent-Benchmark zur Bewegungsvorhersage für autonomes Fahren

Feb 20, 2024 am 11:48 AM

SIMPL: Ein einfacher und effizienter Multi-Agent-Benchmark zur Bewegungsvorhersage für autonomes Fahren

Feb 20, 2024 am 11:48 AM

Originaltitel: SIMPL: ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving Paper-Link: https://arxiv.org/pdf/2402.02519.pdf Code-Link: https://github.com/HKUST-Aerial-Robotics/SIMPL Autor: Hong Kong University of Science und Technologie DJI-Papieridee: Dieses Papier schl?gt eine einfache und effiziente Bewegungsvorhersagebasislinie (SIMPL) für autonome Fahrzeuge vor. Im Vergleich zum herk?mmlichen Agent-Cent

Das Stable Diffusion 3-Papier wird endlich ver?ffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Das Stable Diffusion 3-Papier wird endlich ver?ffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Der Artikel von StableDiffusion3 ist endlich da! Dieses Modell wurde vor zwei Wochen ver?ffentlicht und verwendet die gleiche DiT-Architektur (DiffusionTransformer) wie Sora. Nach seiner Ver?ffentlichung sorgte es für gro?es Aufsehen. Im Vergleich zur Vorg?ngerversion wurde die Qualit?t der von StableDiffusion3 generierten Bilder erheblich verbessert. Es unterstützt jetzt Eingabeaufforderungen mit mehreren Themen, und der Textschreibeffekt wurde ebenfalls verbessert, und es werden keine verstümmelten Zeichen mehr angezeigt. StabilityAI wies darauf hin, dass es sich bei StableDiffusion3 um eine Reihe von Modellen mit Parametergr??en von 800 M bis 8 B handelt. Durch diesen Parameterbereich kann das Modell direkt auf vielen tragbaren Ger?ten ausgeführt werden, wodurch der Einsatz von KI deutlich reduziert wird

Kamera oder Lidar w?hlen? Eine aktuelle übersicht über die Erzielung einer robusten 3D-Objekterkennung

Jan 26, 2024 am 11:18 AM

Kamera oder Lidar w?hlen? Eine aktuelle übersicht über die Erzielung einer robusten 3D-Objekterkennung

Jan 26, 2024 am 11:18 AM

0. Vorab geschrieben&& Pers?nliches Verst?ndnis, dass autonome Fahrsysteme auf fortschrittlichen Wahrnehmungs-, Entscheidungs- und Steuerungstechnologien beruhen, indem sie verschiedene Sensoren (wie Kameras, Lidar, Radar usw.) verwenden, um die Umgebung wahrzunehmen, und Algorithmen und Modelle verwenden für Echtzeitanalysen und Entscheidungsfindung. Dies erm?glicht es Fahrzeugen, Verkehrszeichen zu erkennen, andere Fahrzeuge zu erkennen und zu verfolgen, das Verhalten von Fu?g?ngern vorherzusagen usw. und sich so sicher an komplexe Verkehrsumgebungen anzupassen. Diese Technologie erregt derzeit gro?e Aufmerksamkeit und gilt als wichtiger Entwicklungsbereich für die Zukunft des Transportwesens . eins. Aber was autonomes Fahren schwierig macht, ist herauszufinden, wie man dem Auto klarmachen kann, was um es herum passiert. Dies erfordert, dass der dreidimensionale Objekterkennungsalgorithmus im autonomen Fahrsystem Objekte in der Umgebung, einschlie?lich ihrer Standorte, genau wahrnehmen und beschreiben kann.

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Die Trajektorienvorhersage spielt eine wichtige Rolle beim autonomen Fahren. Unter autonomer Fahrtrajektorienvorhersage versteht man die Vorhersage der zukünftigen Fahrtrajektorie des Fahrzeugs durch die Analyse verschiedener Daten w?hrend des Fahrvorgangs. Als Kernmodul des autonomen Fahrens ist die Qualit?t der Trajektorienvorhersage von entscheidender Bedeutung für die nachgelagerte Planungssteuerung. Die Trajektorienvorhersageaufgabe verfügt über einen umfangreichen Technologie-Stack und erfordert Vertrautheit mit der dynamischen/statischen Wahrnehmung des autonomen Fahrens, hochpr?zisen Karten, Fahrspurlinien, F?higkeiten in der neuronalen Netzwerkarchitektur (CNN&GNN&Transformer) usw. Der Einstieg ist sehr schwierig! Viele Fans hoffen, so schnell wie m?glich mit der Flugbahnvorhersage beginnen zu k?nnen und Fallstricke zu vermeiden. Heute werde ich eine Bestandsaufnahme einiger h?ufiger Probleme und einführender Lernmethoden für die Flugbahnvorhersage machen! Einführungsbezogenes Wissen 1. Sind die Vorschaupapiere in Ordnung? A: Schauen Sie sich zuerst die Umfrage an, S

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fu?g?ngererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der gro?en radialen Verzerrung ist es schwierig, die standardm??ige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell ?fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren