Technologie-Peripherieger?te

Technologie-Peripherieger?te

KI

KI

Wie l?sst sich das Long-Tail-Problem in autonomen Fahrszenarien l?sen?

Wie l?sst sich das Long-Tail-Problem in autonomen Fahrszenarien l?sen?

Wie l?sst sich das Long-Tail-Problem in autonomen Fahrszenarien l?sen?

Jun 02, 2024 pm 02:44 PMIm gestrigen Interview wurde ich gefragt, ob ich jemals Long-Tail-Fragen gestellt h?tte, also dachte ich, ich würde eine kurze Zusammenfassung geben.

Das Long-Tail-Problem selbstfahrender Autos bezieht sich auf Randf?lle bei selbstfahrenden Autos, also m?gliche Szenarien mit geringer Eintrittswahrscheinlichkeit. Das wahrgenommene Long-Tail-Problem ist einer der Hauptgründe, die derzeit den betrieblichen Designbereich intelligenter autonomer Einzelfahrzeugfahrzeuge einschr?nken. Die zugrunde liegende Architektur und die meisten technischen Probleme des autonomen Fahrens wurden gel?st, und die verbleibenden 5 % der Long-Tail-Probleme wurden nach und nach zum Schlüssel zur Einschr?nkung der Entwicklung des autonomen Fahrens. Zu diesen Problemen geh?ren eine Vielzahl fragmentierter Szenarien, Extremsituationen und unvorhersehbares menschliches Verhalten.

Edge-Szenarien beim autonomen Fahren

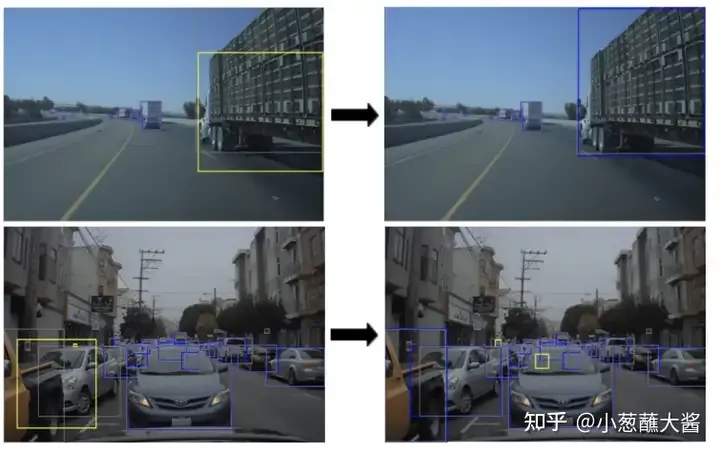

Der ?Long Tail“ bezieht sich auf Edge-Cases bei autonomen Fahrzeugen (AV). Edge-Cases sind m?gliche Szenarien mit geringer Eintrittswahrscheinlichkeit. Diese seltenen Ereignisse werden in Datens?tzen h?ufig übersehen, da sie seltener auftreten und einzigartiger sind. W?hrend Menschen von Natur aus gut im Umgang mit Grenzf?llen sind, kann man das nicht von der KI behaupten. Zu den Faktoren, die Randszenen verursachen k?nnen, geh?ren: Lastkraftwagen oder speziell geformte Fahrzeuge mit Vorsprüngen, Fahrzeuge, die scharf abbiegen, das Fahren in Menschenmengen, Fu?g?nger, die über die Stra?e laufen, extremes Wetter oder schlechte Lichtverh?ltnisse, Personen mit Regenschirmen, Personen in Autos, dann Umzugskartons, umstürzende B?ume mitten auf der Stra?e usw.Beispiel:

- Legen Sie eine transparente Folie vor das Auto. Wird das transparente Objekt erkannt und wird das Fahrzeug langsamer?

- Das Lidar-Unternehmen Aeye hat eine Herausforderung durchgeführt: Wie geht autonomes Fahren damit um? ein Ballon, der mitten auf der Stra?e schwebt? Selbstfahrende Autos der Stufe L4 neigen dazu, Kollisionen zu vermeiden. In diesem Fall werden sie ausweichen oder die Bremsen bet?tigen, um unn?tige Unf?lle zu vermeiden. Der Ballon ist ein weicher Gegenstand und kann ohne Hindernisse direkt passieren.

Methoden zur L?sung des Long-Tail-Problems

Synthetische Daten sind ein gro?es Konzept, und Wahrnehmungsdaten (Nerf, Kamera-/Sensorsimulation) sind nur einer der herausragenderen Zweige. In der Branche sind synthetische Daten l?ngst zur Standardl?sung für Longtail-Verhaltenssimulationen geworden. Synthetische Daten oder sp?rliches Signal-Upsampling sind eine der ersten L?sungen für das Long-Tail-Problem. Die Long-Tail-F?higkeit ist das Produkt aus der Generalisierungsf?higkeit des Modells und der in den Daten enthaltenen Informationsmenge.Tesla-L?sung:

Verwenden Sie synthetische Daten, um Kantenszenen zu generieren und den Datensatz zu erweitern. Prinzip der Daten-Engine: Erkennen Sie zun?chst Ungenauigkeiten im vorhandenen Modell und verwenden Sie dann diesen Klassenfall, der zu seinen Komponententests hinzugefügt wird . Au?erdem werden mehr Daten zu ?hnlichen F?llen gesammelt, um das Modell neu zu trainieren. Dieser iterative Ansatz erm?glicht es, so viele Randf?lle wie m?glich zu erfassen. Die gr??te Herausforderung bei der Erstellung von Randf?llen besteht darin, dass die Kosten für das Sammeln und Beschriften von Randf?llen relativ hoch sind und dass das Sammelverhalten m?glicherweise sehr gef?hrlich oder sogar unm?glich zu erreichen ist.

NVIDIA-L?sung:

NVIDIA hat kürzlich einen strategischen Ansatz namens ?Imitation Training“ vorgeschlagen (Bild unten). Bei diesem Ansatz werden reale Systemausfallf?lle in einer simulierten Umgebung nachgestellt und dann als Trainingsdaten für autonome Fahrzeuge verwendet. Dieser Zyklus wird wiederholt, bis die Leistung des Modells konvergiert. Ziel dieses Ansatzes ist es, die Robustheit des autonomen Fahrsystems durch die kontinuierliche Simulation von Fehlerszenarien zu verbessern. Mithilfe von Simulationsschulungen k?nnen Entwickler verschiedene Fehlerszenarien in der realen Welt besser verstehen und l?sen. Darüber hinaus k?nnen schnell gro?e Mengen an Trainingsdaten generiert werden, um die Modellleistung zu verbessern. Durch Wiederholen dieses Zyklus,

Einige Gedanken:

F: Sind synthetische Daten wertvoll? A: Der Wert ist hier in zwei Typen unterteilt, d. h. die Prüfung, ob in der generierten Szene M?ngel im Erkennungsalgorithmus festgestellt werden k?nnen wird verwendet Ob das Training des Algorithmus auch die Leistung effektiv verbessern kann. F: Wie kann man virtuelle Daten nutzen, um die Leistung zu verbessern? Ist es wirklich notwendig, Dummy-Daten zum Trainingssatz hinzuzufügen? Wird das Hinzufügen zu einem Leistungsrückgang führen? A: Diese Fragen sind schwer zu beantworten, daher wurden viele verschiedene L?sungen zur Verbesserung der Trainingsgenauigkeit entwickelt:- Hybrides Training: Fügen Sie unterschiedliche Anteile virtueller Daten zu realen Daten hinzu, um die Leistung zu verbessern.

- Lernen übertragen: Verwenden Sie reale Daten, um das Modell vorab zu trainieren, frieren Sie dann bestimmte Ebenen ein und fügen Sie dann gemischte Daten für das Training hinzu.

- Imitationslernen: Es ist auch ganz natürlich, einige Szenarien von Modellfehlern zu entwerfen und einige Daten zu generieren, wodurch die Leistung des Modells schrittweise verbessert wird. Bei der tats?chlichen Datenerfassung und dem Modelltraining werden auch einige erg?nzende Daten gezielt erfasst, um die Leistung zu verbessern.

Einige Erweiterungen:

Um die Robustheit eines KI-Systems gründlich zu bewerten, müssen Unit-Tests sowohl allgemeine als auch Randf?lle umfassen. Einige Randf?lle sind jedoch m?glicherweise nicht aus vorhandenen realen Datens?tzen verfügbar. Zu diesem Zweck k?nnen KI-Praktiker synthetische Daten zum Testen verwenden.

Ein Beispiel ist ParallelEye-CS, ein synthetischer Datensatz, der zum Testen der visuellen Intelligenz autonomer Fahrzeuge verwendet wird. Der Vorteil der Erstellung synthetischer Daten im Vergleich zur Verwendung realer Daten besteht in der mehrdimensionalen Kontrolle über die Szene für jedes Bild.

Synthetische Daten werden als praktikable L?sung für Randf?lle in AV-Produktionsmodellen dienen. Es erg?nzt reale Datens?tze mit Randf?llen und stellt sicher, dass AV auch bei ungew?hnlichen Ereignissen robust bleibt. Au?erdem sind sie skalierbarer, weniger fehleranf?llig und kostengünstiger als reale Daten.

Das obige ist der detaillierte Inhalt vonWie l?sst sich das Long-Tail-Problem in autonomen Fahrszenarien l?sen?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Hei?e KI -Werkzeuge

Undress AI Tool

Ausziehbilder kostenlos

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem v?llig kostenlosen KI-Gesichtstausch-Tool aus!

Hei?er Artikel

Hei?e Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Warum ist Gaussian Splatting beim autonomen Fahren so beliebt, dass NeRF allm?hlich aufgegeben wird?

Jan 17, 2024 pm 02:57 PM

Warum ist Gaussian Splatting beim autonomen Fahren so beliebt, dass NeRF allm?hlich aufgegeben wird?

Jan 17, 2024 pm 02:57 PM

Oben geschrieben und pers?nliches Verst?ndnis des Autors. Dreidimensionales Gaussplatting (3DGS) ist eine transformative Technologie, die in den letzten Jahren in den Bereichen explizite Strahlungsfelder und Computergrafik entstanden ist. Diese innovative Methode zeichnet sich durch die Verwendung von Millionen von 3D-Gau?kurven aus, was sich stark von der Neural Radiation Field (NeRF)-Methode unterscheidet, die haupts?chlich ein implizites koordinatenbasiertes Modell verwendet, um r?umliche Koordinaten auf Pixelwerte abzubilden. Mit seiner expliziten Szenendarstellung und differenzierbaren Rendering-Algorithmen garantiert 3DGS nicht nur Echtzeit-Rendering-F?higkeiten, sondern führt auch ein beispielloses Ma? an Kontrolle und Szenenbearbeitung ein. Dies positioniert 3DGS als potenziellen Game-Changer für die 3D-Rekonstruktion und -Darstellung der n?chsten Generation. Zu diesem Zweck geben wir erstmals einen systematischen überblick über die neuesten Entwicklungen und Anliegen im Bereich 3DGS.

Wie l?sst sich das Long-Tail-Problem in autonomen Fahrszenarien l?sen?

Jun 02, 2024 pm 02:44 PM

Wie l?sst sich das Long-Tail-Problem in autonomen Fahrszenarien l?sen?

Jun 02, 2024 pm 02:44 PM

Gestern wurde ich w?hrend des Interviews gefragt, ob ich irgendwelche Long-Tail-Fragen gestellt h?tte, also dachte ich, ich würde eine kurze Zusammenfassung geben. Das Long-Tail-Problem des autonomen Fahrens bezieht sich auf Randf?lle bei autonomen Fahrzeugen, also m?gliche Szenarien mit geringer Eintrittswahrscheinlichkeit. Das wahrgenommene Long-Tail-Problem ist einer der Hauptgründe, die derzeit den betrieblichen Designbereich intelligenter autonomer Einzelfahrzeugfahrzeuge einschr?nken. Die zugrunde liegende Architektur und die meisten technischen Probleme des autonomen Fahrens wurden gel?st, und die verbleibenden 5 % der Long-Tail-Probleme wurden nach und nach zum Schlüssel zur Einschr?nkung der Entwicklung des autonomen Fahrens. Zu diesen Problemen geh?ren eine Vielzahl fragmentierter Szenarien, Extremsituationen und unvorhersehbares menschliches Verhalten. Der ?Long Tail“ von Randszenarien beim autonomen Fahren bezieht sich auf Randf?lle in autonomen Fahrzeugen (AVs). Randf?lle sind m?gliche Szenarien mit geringer Eintrittswahrscheinlichkeit. diese seltenen Ereignisse

SIMPL: Ein einfacher und effizienter Multi-Agent-Benchmark zur Bewegungsvorhersage für autonomes Fahren

Feb 20, 2024 am 11:48 AM

SIMPL: Ein einfacher und effizienter Multi-Agent-Benchmark zur Bewegungsvorhersage für autonomes Fahren

Feb 20, 2024 am 11:48 AM

Originaltitel: SIMPL: ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving Paper-Link: https://arxiv.org/pdf/2402.02519.pdf Code-Link: https://github.com/HKUST-Aerial-Robotics/SIMPL Autor: Hong Kong University of Science und Technologie DJI-Papieridee: Dieses Papier schl?gt eine einfache und effiziente Bewegungsvorhersagebasislinie (SIMPL) für autonome Fahrzeuge vor. Im Vergleich zum herk?mmlichen Agent-Cent

Sparse4D v3 ist da! Weiterentwicklung der End-to-End-3D-Erkennung und -Verfolgung

Nov 24, 2023 am 11:21 AM

Sparse4D v3 ist da! Weiterentwicklung der End-to-End-3D-Erkennung und -Verfolgung

Nov 24, 2023 am 11:21 AM

Neuer Titel: Sparse4Dv3: Advancing End-to-End 3D Detection and Tracking Technology Papierlink: https://arxiv.org/pdf/2311.11722.pdf Der Inhalt, der neu geschrieben werden muss, ist: Codelink: https://github. com/linxuewu/ Inhalt neu geschrieben von Sparse4D: Die Zugeh?rigkeit des Autors ist Horizon Company. Thesenidee: Im autonomen Fahrwahrnehmungssystem sind 3D-Erkennung und -Verfolgung zwei grundlegende Aufgaben. Dieser Artikel befasst sich eingehender mit diesem Bereich basierend auf dem Sparse4D-Framework. In diesem Artikel werden zwei zus?tzliche Trainingsaufgaben vorgestellt (temporales Instanz-Denoising-TemporalInstanceDenoising und Qualit?tssch?tzung-Q).

Kamera oder Lidar w?hlen? Eine aktuelle übersicht über die Erzielung einer robusten 3D-Objekterkennung

Jan 26, 2024 am 11:18 AM

Kamera oder Lidar w?hlen? Eine aktuelle übersicht über die Erzielung einer robusten 3D-Objekterkennung

Jan 26, 2024 am 11:18 AM

0. Vorab geschrieben&& Pers?nliches Verst?ndnis, dass autonome Fahrsysteme auf fortschrittlichen Wahrnehmungs-, Entscheidungs- und Steuerungstechnologien beruhen, indem sie verschiedene Sensoren (wie Kameras, Lidar, Radar usw.) verwenden, um die Umgebung wahrzunehmen, und Algorithmen und Modelle verwenden für Echtzeitanalysen und Entscheidungsfindung. Dies erm?glicht es Fahrzeugen, Verkehrszeichen zu erkennen, andere Fahrzeuge zu erkennen und zu verfolgen, das Verhalten von Fu?g?ngern vorherzusagen usw. und sich so sicher an komplexe Verkehrsumgebungen anzupassen. Diese Technologie erregt derzeit gro?e Aufmerksamkeit und gilt als wichtiger Entwicklungsbereich für die Zukunft des Transportwesens . eins. Aber was autonomes Fahren schwierig macht, ist herauszufinden, wie man dem Auto klarmachen kann, was um es herum passiert. Dies erfordert, dass der dreidimensionale Objekterkennungsalgorithmus im autonomen Fahrsystem Objekte in der Umgebung, einschlie?lich ihrer Standorte, genau wahrnehmen und beschreiben kann.

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Die Trajektorienvorhersage spielt eine wichtige Rolle beim autonomen Fahren. Unter autonomer Fahrtrajektorienvorhersage versteht man die Vorhersage der zukünftigen Fahrtrajektorie des Fahrzeugs durch die Analyse verschiedener Daten w?hrend des Fahrvorgangs. Als Kernmodul des autonomen Fahrens ist die Qualit?t der Trajektorienvorhersage von entscheidender Bedeutung für die nachgelagerte Planungssteuerung. Die Trajektorienvorhersageaufgabe verfügt über einen umfangreichen Technologie-Stack und erfordert Vertrautheit mit der dynamischen/statischen Wahrnehmung des autonomen Fahrens, hochpr?zisen Karten, Fahrspurlinien, F?higkeiten in der neuronalen Netzwerkarchitektur (CNN&GNN&Transformer) usw. Der Einstieg ist sehr schwierig! Viele Fans hoffen, so schnell wie m?glich mit der Flugbahnvorhersage beginnen zu k?nnen und Fallstricke zu vermeiden. Heute werde ich eine Bestandsaufnahme einiger h?ufiger Probleme und einführender Lernmethoden für die Flugbahnvorhersage machen! Einführungsbezogenes Wissen 1. Sind die Vorschaupapiere in Ordnung? A: Schauen Sie sich zuerst die Umfrage an, S

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fu?g?ngererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der gro?en radialen Verzerrung ist es schwierig, die standardm??ige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell ?fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren

Sprechen wir über End-to-End- und autonome Fahrsysteme der n?chsten Generation sowie über einige Missverst?ndnisse über End-to-End-Autonomes Fahren?

Apr 15, 2024 pm 04:13 PM

Sprechen wir über End-to-End- und autonome Fahrsysteme der n?chsten Generation sowie über einige Missverst?ndnisse über End-to-End-Autonomes Fahren?

Apr 15, 2024 pm 04:13 PM

Im vergangenen Monat hatte ich aus bekannten Gründen einen sehr intensiven Austausch mit verschiedenen Lehrern und Mitschülern der Branche. Ein unvermeidliches Thema im Austausch ist natürlich End-to-End und der beliebte Tesla FSDV12. Ich m?chte diese Gelegenheit nutzen, einige meiner aktuellen Gedanken und Meinungen als Referenz und Diskussion darzulegen. Wie definiert man ein durchg?ngiges autonomes Fahrsystem und welche Probleme sollten voraussichtlich durchg?ngig gel?st werden? Gem?? der traditionellsten Definition bezieht sich ein End-to-End-System auf ein System, das Rohinformationen von Sensoren eingibt und für die Aufgabe relevante Variablen direkt ausgibt. Bei der Bilderkennung kann CNN beispielsweise als End-to-End bezeichnet werden, verglichen mit der herk?mmlichen Methode zum Extrahieren von Merkmalen + Klassifizieren. Bei autonomen Fahraufgaben werden Eingabedaten verschiedener Sensoren (Kamera/LiDAR) ben?tigt