Implementierung einer Mikro-Frontend-Architektur

Jul 18, 2025 am 02:07 AMDer Schlüssel zur Implementierung der Micro-Front-End-Architektur liegt in angemessener Aufteilung, stabiler Auswahl und vereinfachter Kommunikation. Die Kernantwort lautet: Kl?ren Sie den Grund für die Trennung und teilen Sie ihn nach Gesch?ftsmodulen, wie z. B. das Disassemblieren von Produktdetails, Einkaufswagen und Bestellzentren des E-Commerce-Systems; Vermeiden Sie eine frühzeitige überm??ige Aufteilung, beginnen Sie mit Modulen mit starker Unabh?ngigkeit. Achten Sie auf die Entkopplung von Unteranwendungen, die Vertretung der ?ffentlichen Ressourcen und ein einheitliches Routing-Design; Zu den Mainstream -L?sungen geh?ren Webkomponenten, IFrames, Modulveration und Qiankun sowie die Auswahl nach Vertrautheit und Bedürfnissen des Teams. Die Kommunikation sollte über URLs übertragen oder so weit wie m?glich auf die Hauptanwendung übertragen werden und nutzen bei Bedarf Ereignisbusse, vermeiden jedoch starke Abh?ngigkeiten.

Die Implementierung der Micro Front-End-Architektur ist eigentlich nicht so mysteri?s, wie sie sich anh?rt. Der Kern besteht darin, eine gro?e Front-End-Anwendung in mehrere kleine Stücke zu teilen, die unabh?ngig entwickelt und eingesetzt werden k?nnen. Der Schlüssel ist, wie man es vernünftig aufteilt, Technologie ohne Werfen ausw?hlt, und der Zusammenarbeitsprozess ist reibungslos.

Die Grenzen der Aufteilung sollten klar sein und nicht zum Abbau abbauen

Das gr??te Missverst?ndnis des Micro-Front-Ends ist, dass Sie über "wie man zerlegt" nachdenken, aber Sie sollten zuerst über "Warum zu zerlegen" denken. Eine g?ngige Praxis besteht darin, sie nach Gesch?ftsmodulen wie dem E-Commerce-System zu teilen, das Produktdetails, Einkaufswagen und Bestellzentren trennt. Der Vorteil dieser Abbaumethode besteht darin, dass sie eine einzige Verantwortung hat und sich bei der Aufrechterhaltung nicht leicht st?rt.

Wenn sich Ihre Anwendung noch in den frühen Phasen befindet, ist die Anzahl der Benutzer nicht gro? und die Funktionen sind nicht kompliziert. Es besteht tats?chlich keine Notwendigkeit, sich mit Mikro-Front-End einzusetzen. Wenn Sie es wirklich zerlegen m?chten, wird auch empfohlen, vom einfachsten Teil des unabh?ngigen, wie dem Hintergrundverwaltungsmodul oder der Datenkarte mit weniger ?nderungen zu beginnen.

Ein paar Punkte, auf die Sie beim Abbau von Bedeutung sind:

- Stellen Sie sicher, dass es keine starke Kopplung zwischen Unteranwendungen gibt

- Vermeiden Sie doppelte Abh?ngigkeiten, ?ffentliche Ressourcen k?nnen getrennt extrahiert und aufrechterhalten werden

- Das Routing -Design muss einheitlich sein, andernfalls gibt es Probleme mit dem Master -Anwendungssprung

W?hlen Sie nicht zu viel Technologie, einfach rennen

Zu den Mainstream -L?sungen geh?ren heutzutage Webkomponenten, Iframes, Modulveration und Qiankun. Jeder hat seine eigenen Vor- und Nachteile. Welche ausgew?hlt wird, h?ngt von der Vertrautheit und den Projektbedürfnissen des Teams ab.

Webkomponenten haben eine gute Kompatibilit?t, aber es ist nicht flexibel genug, um zu schreiben. Iframe ist am einfachsten, aber auch am isoliertesten, und sein Nachteil ist der ?rger der Kommunikation. Die Modulveration ist für React/Vue -Projekte geeignet, die Konfiguration ist jedoch kompliziert. Qiankun ist in China ein vielversprechendes Rahmen mit einer guten Verpackung und geeignet für Teams, die ihre eigenen R?der nicht bauen wollen.

Wenn Ihr Team mit Vue und React vertraut ist und hofft, dass mehrere Unteranwendungen einige UI-Komponentenbibliotheken teilen k?nnen, ist die Modulveration m?glicherweise eine gute Wahl. Wenn Sie jedoch nur schnell online gehen m?chten, um zu überprüfen, ob das Micro Front-End für das aktuelle Projekt geeignet ist, ist es einfacher, IFrame oder Qiankun zu verwenden.

Drehen Sie den Kommunikationsmechanismus nicht um, verwenden Sie weniger so viel wie m?glich

Der Kommunikationsmechanismus des Micro Front-Ends ist oft überentwickelt. In den meisten Szenarien ist nicht erforderlich, dass eine komplexe gemeinsame Nutzung der Sub-Sub-Anwendungsstatus erforderlich ist. Der empfohlene Ansatz lautet: Versuchen Sie, den Wert durch URL -Parameter zu übergeben oder die übertragungskoordination in der Hauptanwendung durchzuführen .

Wenn ein Benutzer beispielsweise auf ein bestimmtes Produkt klickt und die Detail-Seite eingibt, kann er die ID über die Routing-Parameter übergeben, anstatt die Sub-App-Methode direkt aufzurufen. Auf diese Weise wird sich auch dann nicht auf den Gesamtprozess auswirken, wenn einer der Sub-Apps deaktiviert ist.

Natürlich gibt es Ausnahmen wie den globalen Anmeldestatus und Themenwechsel, bei denen mehrere Unteranwendungen gleichzeitig reagieren müssen, die mit einem einfachen Ereignisbus behandelt werden k?nnen. Denken Sie jedoch an eine Sache: Lassen Sie sich nicht direkt auf den Status des anderen verlassen, da es sich ansonsten auf Kopfschmerzen handelt, um sp?ter zu warten.

Grunds?tzlich gibt es nur diese, und es scheint ziemlich viel zu sein. Solange die Demontage vernünftigerweise ist, ist die Auswahl sicher, und die Kommunikation ist vereinfacht, das Micro Front-End ist nicht so schwer zu handhaben.

Das obige ist der detaillierte Inhalt vonImplementierung einer Mikro-Frontend-Architektur. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Hei?e KI -Werkzeuge

Undress AI Tool

Ausziehbilder kostenlos

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem v?llig kostenlosen KI-Gesichtstausch-Tool aus!

Hei?er Artikel

Hei?e Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Vergleichende Analyse von Deep-Learning-Architekturen

May 17, 2023 pm 04:34 PM

Vergleichende Analyse von Deep-Learning-Architekturen

May 17, 2023 pm 04:34 PM

Das Konzept des Deep Learning stammt aus der Erforschung künstlicher neuronaler Netze. Ein mehrschichtiges Perzeptron, das mehrere verborgene Schichten enth?lt, ist eine Deep-Learning-Struktur. Deep Learning kombiniert Funktionen auf niedriger Ebene, um abstraktere Darstellungen auf hoher Ebene zu bilden, um Kategorien oder Merkmale von Daten darzustellen. Es ist in der Lage, verteilte Merkmalsdarstellungen von Daten zu erkennen. Deep Learning ist eine Form des maschinellen Lernens, und maschinelles Lernen ist der einzige Weg, künstliche Intelligenz zu erreichen. Was sind also die Unterschiede zwischen verschiedenen Deep-Learning-Systemarchitekturen? 1. Vollst?ndig verbundenes Netzwerk (FCN) Ein vollst?ndig verbundenes Netzwerk (FCN) besteht aus einer Reihe vollst?ndig verbundener Schichten, wobei jedes Neuron in jeder Schicht mit jedem Neuron in einer anderen Schicht verbunden ist. Sein Hauptvorteil besteht darin, dass es ?strukturunabh?ngig“ ist, d. h. es sind keine besonderen Annahmen über die Eingabe erforderlich. Obwohl dieser strukturelle Agnostiker das Ganze abschlie?t

Was ist die Architektur und das Arbeitsprinzip von Spring Data JPA?

Apr 17, 2024 pm 02:48 PM

Was ist die Architektur und das Arbeitsprinzip von Spring Data JPA?

Apr 17, 2024 pm 02:48 PM

SpringDataJPA basiert auf der JPA-Architektur und interagiert mit der Datenbank über Mapping, ORM und Transaktionsmanagement. Sein Repository bietet CRUD-Operationen und abgeleitete Abfragen vereinfachen den Datenbankzugriff. Darüber hinaus nutzt es Lazy Loading, um Daten nur bei Bedarf abzurufen und so die Leistung zu verbessern.

Handzerrei?en von Llama3 Schicht 1: Implementierung von llama3 von Grund auf

Jun 01, 2024 pm 05:45 PM

Handzerrei?en von Llama3 Schicht 1: Implementierung von llama3 von Grund auf

Jun 01, 2024 pm 05:45 PM

1. Architektur von Llama3 In dieser Artikelserie implementieren wir llama3 von Grund auf. Die Gesamtarchitektur von Llama3: Stellen Sie sich die Modellparameter von Llama3 vor: Werfen wir einen Blick auf die tats?chlichen Werte dieser Parameter im Llama3-Modell. Bild [1] Kontextfenster (Kontextfenster) Beim Instanziieren der LlaMa-Klasse definiert die Variable max_seq_len das Kontextfenster. Es gibt andere Parameter in der Klasse, aber dieser Parameter steht in direktem Zusammenhang mit dem Transformatormodell. Die max_seq_len betr?gt hier 8K. Bild [2] Wortschatzgr??e und AufmerksamkeitL

1,3 ms dauert 1,3 ms! Tsinghuas neueste Open-Source-Architektur für mobile neuronale Netzwerke RepViT

Mar 11, 2024 pm 12:07 PM

1,3 ms dauert 1,3 ms! Tsinghuas neueste Open-Source-Architektur für mobile neuronale Netzwerke RepViT

Mar 11, 2024 pm 12:07 PM

Papieradresse: https://arxiv.org/abs/2307.09283 Codeadresse: https://github.com/THU-MIG/RepViTRepViT funktioniert gut in der mobilen ViT-Architektur und zeigt erhebliche Vorteile. Als n?chstes untersuchen wir die Beitr?ge dieser Studie. In dem Artikel wird erw?hnt, dass Lightweight-ViTs bei visuellen Aufgaben im Allgemeinen eine bessere Leistung erbringen als Lightweight-CNNs, haupts?chlich aufgrund ihres Multi-Head-Selbstaufmerksamkeitsmoduls (MSHA), das es dem Modell erm?glicht, globale Darstellungen zu lernen. Allerdings wurden die architektonischen Unterschiede zwischen Lightweight-ViTs und Lightweight-CNNs noch nicht vollst?ndig untersucht. In dieser Studie integrierten die Autoren leichte ViTs in die effektiven

KI-Infrastruktur: Die Bedeutung der Zusammenarbeit von IT- und Data-Science-Teams

May 18, 2023 pm 11:08 PM

KI-Infrastruktur: Die Bedeutung der Zusammenarbeit von IT- und Data-Science-Teams

May 18, 2023 pm 11:08 PM

Künstliche Intelligenz (KI) hat in vielen Branchen die Spielregeln ver?ndert und es Unternehmen erm?glicht, ihre Effizienz, Entscheidungsfindung und das Kundenerlebnis zu verbessern. Da sich die KI st?ndig weiterentwickelt und immer komplexer wird, ist es für Unternehmen von entscheidender Bedeutung, in die richtige Infrastruktur zu investieren, um ihre Entwicklung und Bereitstellung zu unterstützen. Ein zentraler Aspekt dieser Infrastruktur ist die Zusammenarbeit zwischen IT- und Data-Science-Teams, da beide eine Schlüsselrolle für den Erfolg von KI-Initiativen spielen. Die rasante Entwicklung der künstlichen Intelligenz hat zu steigenden Anforderungen an Rechenleistung, Speicher und Netzwerkf?higkeiten geführt. Diese Nachfrage übt Druck auf die traditionelle IT-Infrastruktur aus, die nicht für die Bew?ltigung der komplexen und ressourcenintensiven Arbeitslasten von KI ausgelegt ist. Aus diesem Grund sind Unternehmen nun auf der Suche nach Systemen, die KI-Workloads unterstützen k?nnen.

Multipfad, Multidom?ne, alles inklusive! Google AI ver?ffentlicht das allgemeine Modell MDL für Multi-Domain-Lernen

May 28, 2023 pm 02:12 PM

Multipfad, Multidom?ne, alles inklusive! Google AI ver?ffentlicht das allgemeine Modell MDL für Multi-Domain-Lernen

May 28, 2023 pm 02:12 PM

Deep-Learning-Modelle für Sehaufgaben (z. B. Bildklassifizierung) werden normalerweise durchg?ngig mit Daten aus einem einzelnen visuellen Bereich (z. B. natürlichen Bildern oder computergenerierten Bildern) trainiert. Im Allgemeinen muss eine Anwendung, die Vision-Aufgaben für mehrere Dom?nen ausführt, mehrere Modelle für jede einzelne Dom?ne erstellen und diese unabh?ngig voneinander trainieren. W?hrend der Inferenz verarbeitet jedes Modell eine bestimmte Dom?ne. Auch wenn sie auf unterschiedliche Bereiche ausgerichtet sind, sind einige Merkmale der frühen Schichten zwischen diesen Modellen ?hnlich, sodass das gemeinsame Training dieser Modelle effizienter ist. Dies reduziert die Latenz und den Stromverbrauch und reduziert die Speicherkosten für die Speicherung jedes Modellparameters. Dieser Ansatz wird als Multi-Domain-Learning (MDL) bezeichnet. Darüber hinaus k?nnen MDL-Modelle auch Single-Modelle übertreffen

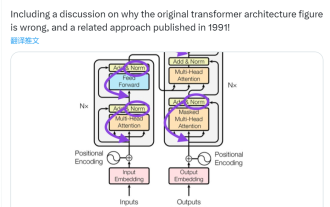

Dieser ?Fehler' ist nicht wirklich ein Fehler: Beginnen Sie mit vier klassischen Aufs?tzen, um zu verstehen, was am Transformer-Architekturdiagramm ?falsch' ist

Jun 14, 2023 pm 01:43 PM

Dieser ?Fehler' ist nicht wirklich ein Fehler: Beginnen Sie mit vier klassischen Aufs?tzen, um zu verstehen, was am Transformer-Architekturdiagramm ?falsch' ist

Jun 14, 2023 pm 01:43 PM

Vor einiger Zeit l?ste ein Tweet, der auf die Inkonsistenz zwischen dem Transformer-Architekturdiagramm und dem Code im Papier ?AttentionIsAllYouNeed“ des Google Brain-Teams hinwies, viele Diskussionen aus. Manche Leute halten Sebastians Entdeckung für einen unbeabsichtigten Fehler, aber sie ist auch überraschend. Angesichts der Popularit?t des Transformer-Papiers h?tte diese Inkonsistenz schlie?lich tausendmal erw?hnt werden müssen. Sebastian Raschka antwortete auf Kommentare von Internetnutzern, dass der ?originellste“ Code zwar mit dem Architekturdiagramm übereinstimme, die 2017 eingereichte Codeversion jedoch ge?ndert, das Architekturdiagramm jedoch nicht gleichzeitig aktualisiert worden sei. Dies ist auch die Ursache für ?inkonsistente“ Diskussionen.

Wie steil ist die Lernkurve der Golang-Framework-Architektur?

Jun 05, 2024 pm 06:59 PM

Wie steil ist die Lernkurve der Golang-Framework-Architektur?

Jun 05, 2024 pm 06:59 PM

Die Lernkurve der Go-Framework-Architektur h?ngt von der Vertrautheit mit der Go-Sprache und der Backend-Entwicklung sowie der Komplexit?t des gew?hlten Frameworks ab: einem guten Verst?ndnis der Grundlagen der Go-Sprache. Es ist hilfreich, Erfahrung in der Backend-Entwicklung zu haben. Frameworks mit unterschiedlicher Komplexit?t führen zu unterschiedlichen Lernkurven.